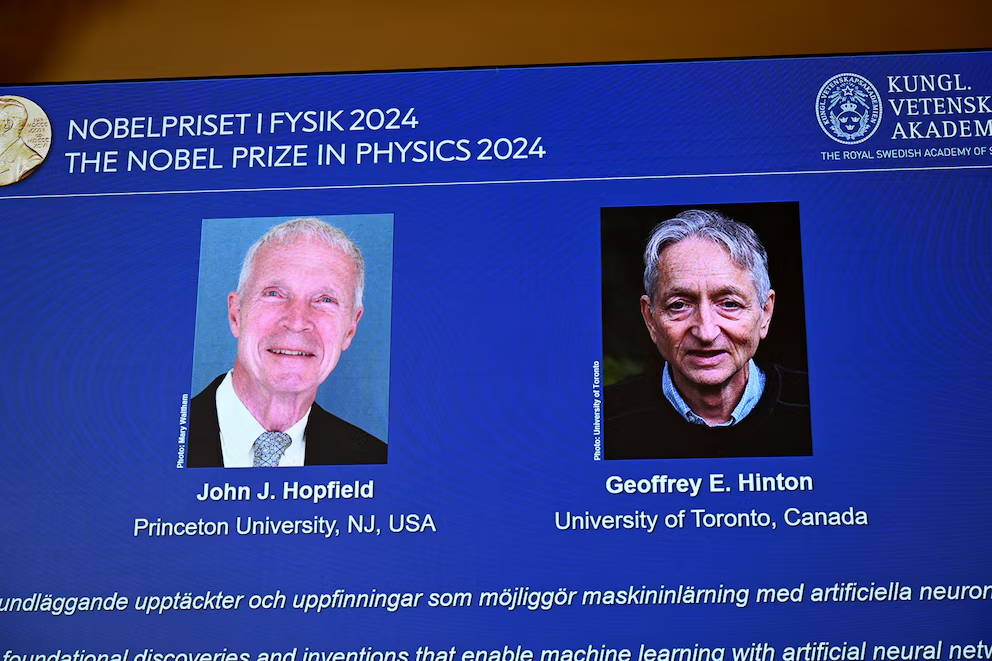

La Real Academia Sueca de Ciencias otorgó el Premio Nobel de Física 2024 al estadounidense John Hopfield y al británico Geoffrey Hinton por sus contribuciones fundamentales al desarrollo del aprendizaje automático, considerado una herramienta clave para la Inteligencia Artificial (IA) tal como la conocemos hoy.

Hopfield nació en 1933 en Chicago y lleva adelante su investigación en la Universidad de Princeton, Estados Unidos. Hinton nació en 1947 en Londres y es investigador en la Universidad de Toronto, Canadá.

Al presentar a los laureados, el comité del Nobel destacó que “aunque las computadoras no pueden pensar, las máquinas pueden ahora imitar funciones como la memoria y el aprendizaje. Los galardonados de este año en Física han contribuido a hacerlo posible”.

Utilizando principios de la física, ambos científicos lograron avances clave que sentaron las bases para las redes neuronales artificiales, una estructura computacional inspirada en el funcionamiento del cerebro. Este hallazgo no solo cambió la forma en que las máquinas procesan y almacenan información, sino que también fue clave para el desarrollo de la inteligencia artificial (IA) moderna, particularmente en el aprendizaje profundo.

Entender el cerebro para crear redes neuronales artificiales

John Hopfield y Geoffrey Hinton fueron reconocidos por su trabajo en algoritmos fundamentales que impulsan la inteligencia artificial moderna, profundizando en las estructuras que imitan la actividad cerebral (Imagen Ilustrativa Infobae)

John Hopfield y Geoffrey Hinton fueron reconocidos por su trabajo en algoritmos fundamentales que impulsan la inteligencia artificial moderna, profundizando en las estructuras que imitan la actividad cerebral (Imagen Ilustrativa Infobae)

El trabajo de Hopfield, de la Universidad de Princenton, y Hinton, de la Universidad de Toronto, está profundamente relacionado con los conceptos de la física y la biología. Aunque hoy asociamos el aprendizaje automático con computadoras y algoritmos, los primeros pasos hacia la creación de redes neuronales artificiales nacieron del deseo de entender cómo funciona el cerebro humano y cómo procesa la información. Hopfield, un físico teórico, jugó un papel decisivo al aplicar conceptos físicos a la neurociencia para explicar cómo el cerebro puede almacenar y recuperar información.

En 1982, desarrolló la red de Hopfield, un modelo de red neuronal artificial que puede almacenar patrones de información y, posteriormente, recuperarlos incluso cuando estos están incompletos o alterados. Este concepto, conocido como memoria asociativa, imita la capacidad humana de recordar, por ejemplo, una palabra que está en la punta de la lengua, procesando otras cercanas en significado hasta encontrar la correcta.

Hopfield aplicó conocimientos de física, como los principios que rigen los sistemas de espín atómico, para crear su red. En física, el espín es una propiedad de las partículas subatómicas que genera un campo magnético. Inspirado por este comportamiento, Hopfield diseñó un sistema en el que las neuronas, o nodos, se conectaban entre sí con diferentes intensidades, de forma similar a cómo los átomos de un material magnético influyen en las direcciones de sus espines vecinos.

Este enfoque permitió a la red asociar y reconstruir patrones de manera eficiente, una idea revolucionaria que marcó el inicio de una nueva era en la computación neuronal. Inspirado en la neurociencia, Hopfield diseñó un modelo que reproduce patrones incluso incompletos, aplicando principios físicos similares al comportamiento de materiales magnéticos (Imagen Ilustrativa Infobae)

Inspirado en la neurociencia, Hopfield diseñó un modelo que reproduce patrones incluso incompletos, aplicando principios físicos similares al comportamiento de materiales magnéticos (Imagen Ilustrativa Infobae)

La Red de Hopfield y memoria asociativa

La red de Hopfield representa un avance significativo porque se basa en un sistema capaz de almacenar múltiples patrones simultáneamente. Cuando se le presenta un patrón incompleto, la red puede encontrar el más cercano entre los que ya memorizó y reconstruyó. Este proceso se asemeja a rodar una bola por un paisaje de picos y valles: si la bola se deja caer cerca de un valle (patrón), rodará hasta el fondo, donde encontrará el patrón más cercano.

En términos técnicos, la red se programa con una imagen en blanco y negro asignando valores binarios a cada nodo (0 para negro, 1 para blanco). Luego, se utiliza una fórmula de energía para ajustar las conexiones entre los nodos, lo que permite a la red reducir la energía total del sistema y, eventualmente, alcanzar un estado estable donde se ha recreado el patrón original. Este enfoque no solo era novedoso, sino que también demostró ser escalable: la red podía almacenar y diferenciar múltiples imágenes, abriendo la puerta a una forma de almacenamiento distribuido de información que más tarde inspiraría los avances en inteligencia artificial.

Hinton y la máquina de Boltzmann

La máquina de Boltzmann de Hinton y el aprendizaje por patrones es un innovador sistema que usa principios de física estadística para prever configuraciones en datos (REUTERS/Mark Blinch/File Photo)

La máquina de Boltzmann de Hinton y el aprendizaje por patrones es un innovador sistema que usa principios de física estadística para prever configuraciones en datos (REUTERS/Mark Blinch/File Photo)

Mientras Hopfield desarrollaba su red, Geoffrey Hinton exploraba cómo las máquinas podrían aprender a procesar patrones de manera similar a los humanos, encontrando sus propias categorías sin necesidad de instrucciones explícitas.

Hinton fue pionero en la máquina de Boltzmann, un tipo de red neuronal que utiliza principios de la física estadística para descubrir estructuras en grandes cantidades de datos.

La física estadística se ocupa de sistemas formados por muchos elementos similares, como las moléculas de un gas, cuyos estados individuales son impredecibles, pero que colectivamente pueden ser analizados para determinar propiedades como la presión y la temperatura. Hinton aprovechó estos conceptos para diseñar una máquina que pudiera analizar la probabilidad de que un conjunto específico de conexiones en una red ocurriera, basándose en la energía de la red en su conjunto. Inspirado por la ecuación de Ludwig Boltzmann, Hinton utilizó esta fórmula para calcular la probabilidad de diferentes configuraciones dentro de la red.

La máquina de Boltzmann tiene dos tipos de nodos: visibles y ocultos. Los primeros reciben la información inicial, mientras que los nodos ocultos generan patrones a partir de esa información, ajustando las conexiones de la red para que los ejemplos entrenados tengan la mayor probabilidad posible de ocurrir. De este modo, la máquina aprende de ejemplos, no de instrucciones, y puede reconocer patrones incluso cuando la información es nueva, pero se asemeja a los ejemplos previamente vistos.

Las bases del aprendizaje profundo de la Inteligencia Artificial

Avances de Hopfield y Hinton sentaron las bases del aprendizaje profundo para el desarrollo de IA moderna (Imagen ilustrativa Infobae)

Avances de Hopfield y Hinton sentaron las bases del aprendizaje profundo para el desarrollo de IA moderna (Imagen ilustrativa Infobae)

El trabajo de Hopfield y Hinton no solo revitalizó el interés por las redes neuronales, sino que también abrió la puerta al desarrollo del aprendizaje profundo, una rama de la IA que hoy en día impulsa gran parte de las innovaciones tecnológicas, desde los asistentes virtuales hasta los vehículos autónomos.

Las redes neuronales profundas, que son modelos con muchas capas de neuronas, deben su existencia a estos avances tempranos en las redes neuronales artificiales.

En la actualidad, las redes neuronales son herramientas fundamentales para analizar grandes cantidades de datos, identificar patrones complejos en imágenes y sonidos, y mejorar la toma de decisiones en sectores que van desde la medicina hasta la astrofísica.

Por ejemplo, en la física de partículas, las redes neuronales artificiales han sido fundamentales para descubrir la partícula de Higgs, un logro galardonado con el Premio Nobel de Física en 2013. Asimismo, el aprendizaje automático ha permitido mejorar la detección de ondas gravitacionales, otro hito científico reciente.

Gracias a los descubrimientos de Hopfield y Hinton, la IA sigue evolucionando a un ritmo vertiginoso. En el campo de la biología molecular, por ejemplo, las redes neuronales se utilizan para predecir la estructura de proteínas, lo que tiene implicaciones directas en el desarrollo de medicamentos. Además, en la energía renovable, las redes se están utilizando para diseñar materiales con mejores propiedades para células solares más eficientes.